Contexto é Rei: A Nova Forma de Usar IA

FEATURED ATTACHMENT

FEATURED ATTACHMENT Você ainda está usando IA como um Google mais inteligente? Fazendo perguntas e esperando respostas úteis?

Eu estava também. E estava perdendo o ponto.

O Problema: IA Sem Contexto

Vou ser honesto:

Eles não sabem nada sobre você.

Eles não sabem sobre seu trabalho. Não sabem que reuniões você tem agendadas. Não sabem que tarefas estão se acumulando na sua lista de afazeres. Não conhecem o codebase em que você está trabalhando ou os documentos que seu time compartilha. Eles não sabem sobre você.

Toda empresa hoje tem seu próprio “ChatGPT interno”. Um wrapper com o logo da empresa, integrado no Slack, respondendo perguntas sobre documentação…

Mas ele só responde. E honestamente? Nem bem — porque falta contexto. Ele não faz nada, e mesmo quando tenta ajudar, as respostas são genéricas. Imagine uma IA que não só responde muito melhor porque conhece seu mundo, mas também age — e age com precisão.

A Mudança: Contexto é Rei

Aqui está o que aprendi: a nova forma de usar IA não é sobre criar

Quando a IA tem contexto sobre seu ambiente — seus emails, seu calendário, seus documentos, suas ferramentas — algo mágico acontece. Ela para de apenas responder e começa a agir.

Em vez de perguntar “Como devo organizar meus emails?” você pode dizer “Analise meus emails de hoje, resuma os importantes e crie tarefas para qualquer coisa que precise de ação.”

E ela simplesmente… faz.

IA Sem Contexto

Respostas genéricas que servem para qualquer um

- Copiar-colar informações manualmente

- Adaptar respostas genéricas para sua situação

- Fazer o trabalho real você mesmo

- IA como 'autocomplete chique'

IA Com Contexto

Ações personalizadas baseadas no seu mundo

- IA entende seu ambiente

- Recebe respostas específicas e acionáveis

- Automatiza tarefas reais de ponta a ponta

- IA como verdadeiro assistente

MCP: O Protocolo Tornando Isso Possível

Se você não ouviu falar do

Pense nisso: antes do MCP, toda integração era customizada. Quer que o Claude acesse seu banco de dados? Escreva um plugin. Quer que ele envie emails? Outro plugin. Cada um com sua própria API, autenticação, formato de dados.

O MCP padroniza tudo isso.

Como o MCP Funciona

1. Conexão

O cliente se conecta ao MCP Server via SSE (Server-Sent Events) ou stdio.

2. Descoberta

O cliente lista todas as ferramentas disponíveis (tools/list).

3. Prompt

Ferramentas são enviadas ao LLM junto com a mensagem do usuário.

4. Uso de Ferramenta

O LLM decide qual ferramenta usar e retorna um tool_use com argumentos.

5. Execução

O cliente executa a ferramenta no MCP Server e retorna o resultado ao LLM.

O ponto chave aqui é: o LLM decide qual ferramenta usar. Você apenas passa a lista de ferramentas disponíveis e ele automaticamente escolhe baseado no contexto da conversa.

Na prática:

- Conecte Gmail → IA pode ler, pesquisar, resumir e enviar seus emails

- Conecte Calendário → IA pode verificar disponibilidade, agendar reuniões e bloquear horários

- Conecte Notion → IA pode criar páginas, atualizar bancos de dados e organizar suas notas

- Conecte GitHub → IA pode revisar PRs, criar issues e verificar status de builds

Pense nisso como um adaptador universal. Em vez de construir integrações customizadas para cada ferramenta de IA, o MCP fornece uma linguagem comum. Qualquer cliente compatível com MCP (como

Se você quiser se aprofundar no MCP, confira a documentação oficial e o anúncio da Anthropic.

TrampoAI: Da Teoria à Prática

Para entender como isso funciona na prática, construí o TrampoAI — um cliente MCP completo com interface de chat.

Arquitetura

┌─────────────┐ ┌─────────────┐ ┌─────────────────┐

│ React │────▶│ Express │────▶│ MCP Servers │

│ (Vite) │◀────│ Backend │◀────│ (via SSE) │

└─────────────┘ └──────┬──────┘ └─────────────────┘

│

▼

┌─────────────┐

│ Anthropic │

│ API │

└─────────────┘O fluxo é simples:

- Frontend envia uma mensagem para o backend

- Backend coleta ferramentas de todos os MCP Servers conectados

- Backend envia mensagem + ferramentas para a API da Anthropic

- Claude responde com

tool_usese precisar executar algo - Backend executa a ferramenta no MCP Server correspondente

- Backend envia o

tool_resultde volta para o Claude - Claude gera a resposta final

Stack

Demo: Um Prompt, Quatro Ferramentas

Aqui está o TrampoAI em ação. Conectei três serviços:

Meus Serviços Conectados

Então perguntei algo assim:

“Leia meus últimos 10 emails, resuma-os, encontre os que preciso tomar ação, crie tarefas no Notion, e bloqueie 1 hora às 15h hoje no meu calendário para trabalhar neles.”

Veja o que acontece:

Com um prompt, Claude automaticamente:

- Chamou o MCP do Gmail para ler meus emails

- Resumiu e filtrou quais precisavam de ação

- Chamou o MCP do Notion para criar tarefas

- Chamou o MCP do Google Calendar para bloquear horário

Sem orquestração manual. Sem workflows hardcoded. O LLM descobriu quais ferramentas usar e em que ordem.

Esta é a diferença entre IA que informa e IA que age. Eu não pedi informação. Pedi ação. E porque a IA tinha contexto sobre meu email, meu calendário e meu sistema de gestão de tarefas, ela realmente conseguiu entregar.

O Problema de Escala: MCP Mess

Ok, funciona. Mas o que acontece quando você tem 10 MCP Servers? 50? 100?

MCP Ingênuo

Cada cliente se conecta a cada MCP Server

- N clientes × M servidores = N×M conexões

- Cada cliente gerencia suas próprias credenciais

- Sem controle de acesso centralizado

- Sem observabilidade unificada

O Problema

Isso não escala

- Explosão de conexões

- Credenciais espalhadas

- Quem acessou o quê?

- Quanto estamos gastando?

Construindo o TrampoAI, percebi na prática: gerenciar múltiplos MCP Servers é um pesadelo.

Cada servidor tem sua própria conexão, suas próprias ferramentas, suas próprias credenciais. Não há como saber quem executou o quê, quanto custou, se alguém está abusando do sistema.

A Solução: MCP Mesh

É aqui que o MCP Mesh da Deco entra.

A ideia é simples: em vez de cada cliente se conectar diretamente a cada MCP Server, você tem um plano de controle no meio.

E honestamente? Configurar foi ridiculamente fácil. Rodei o projeto Deco localmente, abri a loja de MCPs deles, cliquei para autenticar os MCPs que queria (Gmail, Notion, Calendário), selecionei as ferramentas que precisava, e exportei tudo como um único link — esse é o mesh. Aquela URL é o que usei no TrampoAI. Sem configuração manual para cada servidor. Sem malabarismo de credenciais. Apenas clique, autentique, exporte. Pronto.

Arquitetura MCP Mesh

O MCP Mesh fornece:

1. Um Endpoint para Tudo

Não importa quantos MCP Servers você tem. Seus clientes se conectam a um único endpoint. O Mesh roteia para as ferramentas certas.

2. RBAC e Políticas

Controle de acesso no nível do plano de controle. Quem pode usar qual ferramenta? Precisa de aprovação para executar? Tudo configurável.

3. Observabilidade

Logs unificados para todas as execuções. Latência, erros, custos — tudo em um lugar.

4. Roteamento Inteligente

Quando você tem muitas ferramentas, enviar todas para o LLM fica caro (tokens) e lento. O Mesh tem estratégias de seleção inteligentes.

5. Sem Vendor Lock-in

Open-source, self-hosted. Roda no seu Kubernetes, na sua infraestrutura. Você está no controle.

# Rode localmente em 1 minuto

npx @decocms/meshTrabalho na Deco, então sou obviamente enviesado. Mas genuinamente acredito que essa é a direção que as coisas estão indo. Conforme a adoção do MCP cresce, a necessidade de infraestrutura adequada para gerenciá-lo se torna crítica — assim como APIs precisavam de

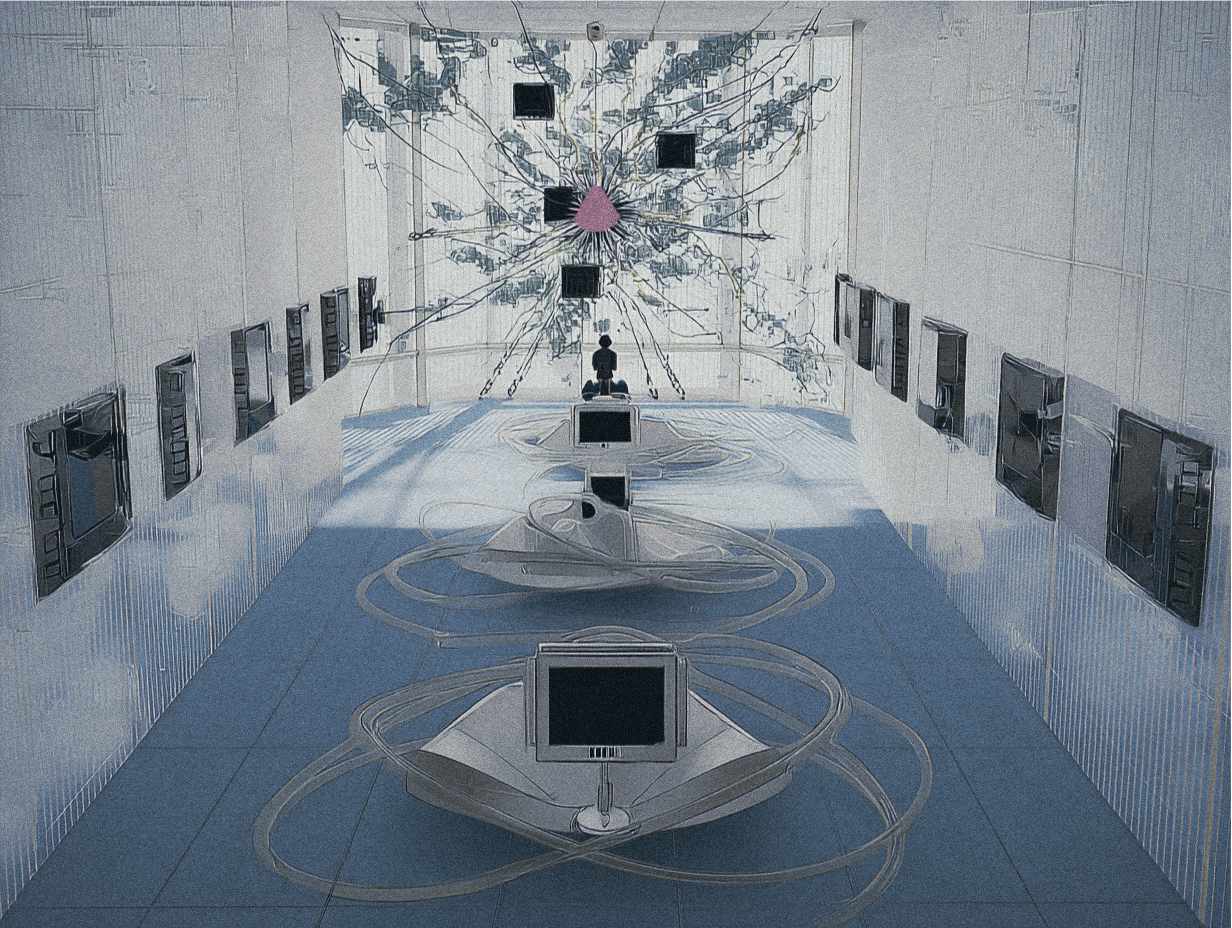

Um Vislumbre do Futuro

Deixa eu compartilhar algo em que tenho pensado muito.

Imagino um futuro onde todos têm seu próprio mesh MCP pessoal — uma rede de conexões com todos os seus contextos, suas informações, suas ferramentas, sua vida. E junto com ele, seu próprio agente de IA. Não um produto que você usa. Um companheiro que conhece você.

Pense nisso: você está andando por aí, conversando com sua IA sobre uma ideia que acabou de ter. Você diz para ela salvar uma nota. Você pergunta sobre aquela mensagem que seu amigo mandou ontem. Você pensa em voz alta como sua semana está, e ela simplesmente te conta — porque ela sabe. Ela tem acesso a tudo que você deu permissão para ela ver.

Seus emails, seu calendário, suas notas, suas mensagens, seus documentos, suas fotos, sua música, suas finanças — tudo conectado, tudo contextual, tudo seu.

Isso não é ficção científica. As peças já estão aqui. MCP é o protocolo. O mesh é a infraestrutura. Os agentes estão ficando mais inteligentes a cada dia. O que falta é apenas tempo — e adoção.

Realmente acredito que estamos caminhando para um mundo onde sua IA não é apenas uma ferramenta que você abre quando precisa de algo. Ela está sempre lá, sempre ciente do seu contexto, sempre pronta para ajudar. Como ter um amigo brilhante que nunca esquece nada e está genuinamente tentando tornar sua vida mais fácil.

Esse é o futuro que me empolga. E honestamente? Estamos mais perto do que a maioria das pessoas pensa.

O Que Aprendi

Construir o TrampoAI foi prova real de como as coisas funcionam por baixo dos panos.

Principais Aprendizados

MCP é simples

O protocolo em si é elegante. SSE + JSON-RPC. Fácil de implementar.

Contexto muda tudo

Um modelo menor com seu contexto supera um modelo maior sem ele.

Gerenciar é complexo

Múltiplos servidores, credenciais, conexões... rapidamente vira caos.

Você precisa de um Mesh

Para produção, você precisa de um plano de controle. Simples assim.

Conclusão

Aqui está minha visão: o próximo salto na utilidade da IA não virá de modelos maiores ou treinamento melhor. Virá de contexto melhor.

Um modelo com conhecimento perfeito e zero contexto sobre sua vida é menos útil que um modelo menor que sabe exatamente em que você está trabalhando, o que precisa fazer e que ferramentas tem disponíveis.

Estamos saindo de “IA como oráculo” para “IA como assistente.” Um oráculo responde perguntas. Um assistente conhece seu mundo e age dentro dele.

Sua IA é tão útil quanto o contexto que você dá a ela.

Se você quer entender como isso funciona na prática, confira o TrampoAI. É open-source e você pode rodar localmente em 5 minutos.

E se você quer explorar IA contextual por conta própria, comece pequeno. Escolha uma ferramenta que você usa diariamente — talvez seu calendário ou app de notas — e encontre um servidor MCP para ela. Conecte ao seu cliente de IA e veja o que se torna possível.

A mudança de IA genérica para contextual não está vindo. Ela já está aqui.

Me conta o que você acha nas minhas redes. Adoraria ouvir como você está usando IA contextual nos seus workflows!